概述

概念与记号

计算学习理论 (computational learning theory)研究的是关于通过「计算」来进行「学习」的理论,即关于机器学习的理论基础,其目的是分析学习任务的困难本质,为学习算法提供理论保证,并根据分析结果指导算法设计。

关注的问题:

怎样刻画「学习」这个过程?

什么样的问题是「可学习的」?

什么样的问题是「易学习的」?

对于给定的学习算法,能否在理论上预测其性能?

理论结果如何指导现实问题的算法设计?

一些相关的概念与记号:

样例集 D = { ( x i , y i ) } i = 1 m D = \left\lbrace (\bm{x}_i, y_i) \right\rbrace_{i=1}^m D = { ( x i , y i ) } i = 1 m x i ∈ X \bm{x}_i \in \mathcal{X} x i ∈ X y i ∈ Y = { − 1 , 1 } y_i \in \mathcal{Y} = \left\lbrace -1, 1 \right\rbrace y i ∈ Y = { − 1 , 1 } X \mathcal{X} X D \mathcal{D} D D D D D \mathcal{D} D 令 h h h X \mathcal{X} X Y \mathcal{Y} Y

泛化误差 E ( h ; D ) = P x ∼ D ( h ( x ) ≠ y ) E(h; D) = P_{\bm{x} \sim \mathcal{D}}(h(\bm{x}) \ne y) E ( h ; D ) = P x ∼ D ( h ( x ) = y ) 经验误差 E ^ ( h ; D ) = 1 m ∑ i = 1 m I ( h ( x i ) ≠ y i ) \hat{E}(h; D) = \dfrac{1}{m} \displaystyle \sum_{i=1}^m \mathbb{I}(h(\bm{x}_i) \ne y_i) E ^ ( h ; D ) = m 1 i = 1 ∑ m I ( h ( x i ) = y i ) 由于 D D D D \mathcal{D} D h h h E ( h ) E(h) E ( h ) E ^ ( h ) \hat{E}(h) E ^ ( h )

误差参数 ϵ \epsilon ϵ E ( h ) E(h) E ( h ) E ( h ) ⩽ ϵ E(h) \le \epsilon E ( h ) ⩽ ϵ 若 h h h D D D 0 0 0 h h h D D D 一致 ,否则称 h h h D D D

对于任意两个映射 h 1 , h 2 ∈ X → Y h_1, h_2 \in \mathcal{X} \to \mathcal{Y} h 1 , h 2 ∈ X → Y 不合 (disagreement)度量它们之间的差别:d ( h 1 , h 2 ) = P x ∼ D ( h 1 ( x ) ≠ h 2 ( x ) ) d(h_1, h_2) = P_{\bm{x} \sim \mathcal{D}}(h_1(\bm{x}) \ne h_2(\bm{x})) d ( h 1 , h 2 ) = P x ∼ D ( h 1 ( x ) = h 2 ( x ))

什么是「学习」

概念 (concept)是从样本空间 X \mathcal{X} X Y \mathcal{Y} Y x \bm{x} x y y y

目标概念:若对任何样例 ( x , y ) (\bm{x}, y) ( x , y ) c ( x ) = y c(\bm{x}) = y c ( x ) = y c c c 目标概念 。

概念类:所有我们希望学得的目标概念所构成的集合称为概念类 (concept class),记为 C \mathcal{C} C

给定学习算法 L \mathfrak{L} L 假设空间 (hypothesis space),记为 H \mathcal{H} H

由于学习算法事先并不知道概念类的真实存在,因此 H , C \mathcal{H}, \mathcal{C} H , C H \mathcal{H} H

对于 h ∈ H h \in \mathcal{H} h ∈ H 假设 (hypothesis)。

学习过程可以视为 L \mathfrak{L} L H \mathcal{H} H

可分的与不可分的:

可分的:若目标概念 c ∈ H c \in \mathcal{H} c ∈ H H \mathcal{H} H L \mathfrak{L} L 可分的 (separable),也称为一致的 (consistent)。

不可分的:若目标概念 c ∉ H c \notin \mathcal{H} c ∈ / H H \mathcal{H} H L \mathfrak{L} L 不可分的 (non-separable),也称为不一致的 (inconsistent)。

对于给定训练集 D D D L \mathfrak{L} L h h h c c c

为何不是希望精确地学到目标概念 c c c

获得的训练集 D D D D D D

从分布 D \mathcal{D} D D D D

可学习性

概率近似正确 (Probably Approximately Correct, PAC):我们希望以较大的把握学得比较好的模型,即以较大概率学得误差满足预设上限的模型 。

令 δ \delta δ

PAC 辨识(PAC Identify)

对 0 < ϵ , δ < 1 0 < \epsilon, \delta < 1 0 < ϵ , δ < 1 c ∈ C c \in \mathcal{C} c ∈ C D \mathcal{D} D L \mathfrak{L} L h ∈ H h \in \mathcal{H} h ∈ H

P ( E ( h ) ⩽ ϵ ) ⩾ 1 − δ P(E(h) \le \epsilon) \ge 1 - \delta

P ( E ( h ) ⩽ ϵ ) ⩾ 1 − δ

则称学习算法 L \mathfrak{L} L H \mathcal{H} H C \mathcal{C} C

这样的学习算法 L \mathfrak{L} L 1 − δ 1 - \delta 1 − δ c c c ϵ \epsilon ϵ

令 m m m D \mathcal{D} D D \mathcal{D} D L \mathfrak{L} L poly \operatorname{poly} poly m ⩾ poly ( 1 ϵ , 1 δ , size ( x ) , size ( c ) ) m \ge \operatorname{poly}\left(\frac{1}{\epsilon}, \frac{1}{\delta}, \operatorname{size}(\bm{x}), \operatorname{size}(c)\right) m ⩾ poly ( ϵ 1 , δ 1 , size ( x ) , size ( c ) ) L \mathfrak{L} L H \mathcal{H} H C \mathcal{C} C 概念类 C \mathcal{C} C H \mathcal{H} H ,简称概念类 C \mathcal{C} C

若考虑对应学习算法 L \mathfrak{L} L

PAC 学习算法(PAC Learning Algorithm)

若学习算法使概念类 C \mathcal{C} C L \mathfrak{L} L poly ( 1 ϵ , 1 δ , size ( x ) , size ( c ) ) \operatorname{poly}\left(\frac{1}{\epsilon}, \frac{1}{\delta}, \operatorname{size}(\bm{x}), \operatorname{size}(c)\right) poly ( ϵ 1 , δ 1 , size ( x ) , size ( c ) ) C \mathcal{C} C L \mathfrak{L} L C \mathcal{C} C

假定学习算法 L \mathfrak{L} L L \mathfrak{L} L

样本复杂度

满足 PAC 学习算法 L \mathfrak{L} L m m m L \mathfrak{L} L 样本复杂度 (sample complexity)。

PAC 学习的意义:

给出了一个抽象地刻画机器学习能力的框架,基于这个框架可以

研究某任务在什么样的条件下可学得较好的模型?

某算法在什么样的条件下可进行有效的学习?

需要多少训练样例才能获得较好的模型?

把对复杂算法的时间复杂度的分析转为对样本复杂度的分析

假设空间 H \mathcal{H} H

一般而言 H \mathcal{H} H

∣ H ∣ |\mathcal{H}| ∣ H ∣

若假设空间 H \mathcal{H} H L \mathfrak{L} L H = C \mathcal{H} = \mathcal{C} H = C

直观地看,这意味着学习算法的能力与学习任务「恰好匹配」,即所有候选假设都来自概念类。

然而在现实应用中我们对概念类通常一无所知,设计一个假设空间与概念类恰好相同的学习算法通常是不切实际的.

研究的重点在于假设空间与概念类不同时,即 H ≠ C \mathcal{H} \neq \mathcal{C} H = C

有限假设空间

可分情况

目标概念 c c c H \mathcal{H} H c ∈ H c \in \mathcal{H} c ∈ H

一种简单的学习策略:

由于 c ∈ H c \in \mathcal{H} c ∈ H D D D c c c

保留与 D D D D D D

若 D D D D D D H \mathcal{H} H c c c

通常情况下由于训练集规模有限,假设空间 H \mathcal{H} H D D D D D D

需要多少样例才能学得目标概念的有效近似?

训练集 D D D L \mathfrak{L} L 1 − δ 1 - \delta 1 − δ ϵ \epsilon ϵ

m ⩾ 1 ϵ ( ln ∣ H ∣ + ln 1 δ ) m \ge \dfrac{1}{\epsilon} \left( \ln |\mathcal{H}| + \ln \dfrac{1}{\delta} \right)

m ⩾ ϵ 1 ( ln ∣ H ∣ + ln δ 1 )

可分情况下的有限假设空间 H \mathcal{H} H h h h 0 0 0 O ( 1 m ) O\left(\dfrac{1}{m}\right) O ( m 1 )

不可分情况

对于较困难的学习任务,c ∉ H c \notin \mathcal{H} c ∈ / H h ∈ H , E ^ ( h ) ≠ 0 h \in \mathcal{H}, \hat{E}(h) \ne 0 h ∈ H , E ^ ( h ) = 0

若 H \mathcal{H} H 0 < δ < 1 0 < \delta < 1 0 < δ < 1 h ∈ H h \in \mathcal{H} h ∈ H

P ( ∣ E ( h ) − E ^ ( h ) ∣ ⩽ ln ∣ H ∣ + ln ( 2 / δ ) 2 m ) ⩾ 1 − δ P\left(|E(h) - \hat{E}(h)| \le \sqrt{\dfrac{\ln |\mathcal{H}| + \ln (2 / \delta)}{2m}}\right) \ge 1 - \delta

P ( ∣ E ( h ) − E ^ ( h ) ∣ ⩽ 2 m ln ∣ H ∣ + ln ( 2/ δ ) ) ⩾ 1 − δ

这表明样本大小 m m m h h h c ∉ H c \notin \mathcal{H} c ∈ / H H \mathcal{H} H

因此这实际上指出了一种通用的学习原则,即经验风险最小化 (Empirical Risk Minimization, ERM)原则:令 h h h L \mathfrak{L} L h h h

E ^ ( h ) = min h ′ ∈ H E ^ ( h ′ ) \hat{E}(h) = \min_{h' \in \mathcal{H}} \hat{E}(h')

E ^ ( h ) = h ′ ∈ H min E ^ ( h ′ )

则称 L \mathfrak{L} L

c ∉ H c \notin \mathcal{H} c ∈ / H

不可知 PAC 可学习(agnostic PAC learneable)

令 m m m D \mathcal{D} D 0 < ϵ , δ < 1 0 < \epsilon, \delta < 1 0 < ϵ , δ < 1 D \mathcal{D} D L \mathfrak{L} L poly \operatorname{poly} poly m ⩾ poly ( 1 ϵ , 1 δ , size ( x ) , size ( c ) , ∣ H ∣ ) m \ge \operatorname{poly}\left(\frac{1}{\epsilon}, \frac{1}{\delta}, \operatorname{size}(\bm{x}), \operatorname{size}(c), |\mathcal{H}|\right) m ⩾ poly ( ϵ 1 , δ 1 , size ( x ) , size ( c ) , ∣ H ∣ ) L \mathfrak{L} L H \mathcal{H} H

P ( E ( h ) − min h ′ ∈ H E ( h ′ ) ⩽ ϵ ) ⩾ 1 − δ P(E(h) - \min_{h' \in \mathcal{H}} E(h') \le \epsilon) \ge 1 - \delta

P ( E ( h ) − h ′ ∈ H min E ( h ′ ) ⩽ ϵ ) ⩾ 1 − δ

则称假设空间 H \mathcal{H} H

有限假设集是不可知 PAC 可学习的。

无限假设空间

现实学习任务所面临的通常是无线假设空间,例如实数域的所有区间,R d \R^d R d

这种情况下需要使用 ∣ H ∣ |\mathcal{H}| ∣ H ∣

VC 维(Vapnik-Chervonenkis dimension)

Rademacher 复杂度(Rademacher complexity)

VC 维

给定假设空间 H \mathcal{H} H { x i } i = 1 m \left\lbrace \bm{x}_i \right\rbrace_{i=1}^m { x i } i = 1 m H \mathcal{H} H h h h D D D

h ∣ D = { ( h ( x 1 ) , h ( x 2 ) , … , h ( x m ) ) } h|_D = \left\lbrace \left(h(\bm{x}_1), h(\bm{x}_2), \dots, h(\bm{x}_m) \right)\right\rbrace

h ∣ D = { ( h ( x 1 ) , h ( x 2 ) , … , h ( x m ) ) }

假设空间 H \mathcal{H} H D D D

尽管 H \mathcal{H} H D D D m m m 2 m 2^m 2 m

增长函数(growth function)

对所有 m ∈ N m \in \N m ∈ N H \mathcal{H} H Π H \Pi_{\mathcal{H}} Π H

Π H ( m ) = max { x i } i = 1 m ∣ { h ∣ D : h ∈ H } ∣ \Pi_{\mathcal{H}}(m) = \max_{\left\lbrace \bm{x}_i \right\rbrace_{i=1}^m} \left| \left\lbrace h|_D : h \in \mathcal{H} \right\rbrace \right|

Π H ( m ) = { x i } i = 1 m max ∣ { h ∣ D : h ∈ H } ∣

增长函数表示假设空间对 m m m

H \mathcal{H} H H \mathcal{H} H

增长函数表述了 H \mathcal{H} H

可利用增长函数估计经验误差与泛化误差之间的关系:

对假设空间 H \mathcal{H} H m ∈ N , 0 < ϵ < 1 m \in \N, 0 < \epsilon < 1 m ∈ N , 0 < ϵ < 1 h ∈ H h \in \mathcal{H} h ∈ H

P ( ∣ E ( h ) − E ^ ( h ) ∣ > ϵ ) ⩽ 4 Π H ( 2 m ) exp ( − m ϵ 2 8 ) P\left( |E(h) - \hat{E}(h)| > \epsilon \right) \le 4 \Pi_{\mathcal{H}}(2m) \exp\left(-\dfrac{m\epsilon^2}{8}\right)

P ( ∣ E ( h ) − E ^ ( h ) ∣ > ϵ ) ⩽ 4 Π H ( 2 m ) exp ( − 8 m ϵ 2 )

对二分类任务来说,H \mathcal{H} H D D D D D D 对分 (dichotomy)。

若 H \mathcal{H} H D D D D D D H \mathcal{H} H 打散 (shattered)。

VC 维(Vapnik-Chervonenkis dimension)

假设空间 H \mathcal{H} H VC 维 是能被 H \mathcal{H} H

VC ( H ) = max { m : Π H ( m ) = 2 m } \operatorname{VC}(\mathcal{H}) = \max\left\lbrace m \colon \Pi_{\mathcal{H}}(m) = 2^m \right\rbrace

VC ( H ) = max { m : Π H ( m ) = 2 m }

VC ( H ) = d \operatorname{VC}(\mathcal{H}) = d VC ( H ) = d d d d H \mathcal{H} H d d d H \mathcal{H} H

例子:

令 H \mathcal{H} H { h [ a , b ] : a , b ∈ R , a ⩽ b } \left\lbrace h_{[a, b]}\colon a, b \in \R,\, a \le b\right\rbrace { h [ a , b ] : a , b ∈ R , a ⩽ b } X = R \mathcal{X} = \R X = R x ∈ X x \in \mathcal{X} x ∈ X x ∈ [ a , b ] x \in [a, b] x ∈ [ a , b ] h [ a , b ] ( x ) = 1 h_{[a, b]}(x) = 1 h [ a , b ] ( x ) = 1 h [ a , b ] ( x ) = − 1 h_{[a, b]}(x) = -1 h [ a , b ] ( x ) = − 1

令 x 1 = 0.5 , x 2 = 1.5 x_1 = 0.5, x_2 = 1.5 x 1 = 0.5 , x 2 = 1.5 H \mathcal{H} H { h [ 0 , 1 ] , h [ 0 , 2 ] , h [ 1 , 2 ] , h [ 2 , 3 ] } \left\lbrace h_{[0, 1]},\, h_{[0, 2]},\, h_{[1, 2]},\, h_{[2, 3]} \right\rbrace { h [ 0 , 1 ] , h [ 0 , 2 ] , h [ 1 , 2 ] , h [ 2 , 3 ] } { x 1 , x 2 } \left\lbrace x_1, x_2 \right\rbrace { x 1 , x 2 } H \mathcal{H} H 2 2 2

对任意大小为 3 3 3 { x 3 , x 4 , x 5 } \left\lbrace x_3, x_4, x_5 \right\rbrace { x 3 , x 4 , x 5 } x 3 < x 4 < x 5 x_3 < x_4 < x_5 x 3 < x 4 < x 5 H \mathcal{H} H h [ a , b ] h_{[a, b]} h [ a , b ] { ( x 3 , 1 ) , ( x 4 , − 1 ) , ( x 5 , 1 ) } \left\lbrace (x_3, 1),\, (x_4, -1),\, (x_5, 1) \right\rbrace { ( x 3 , 1 ) , ( x 4 , − 1 ) , ( x 5 , 1 ) }

因此 H \mathcal{H} H 2 2 2

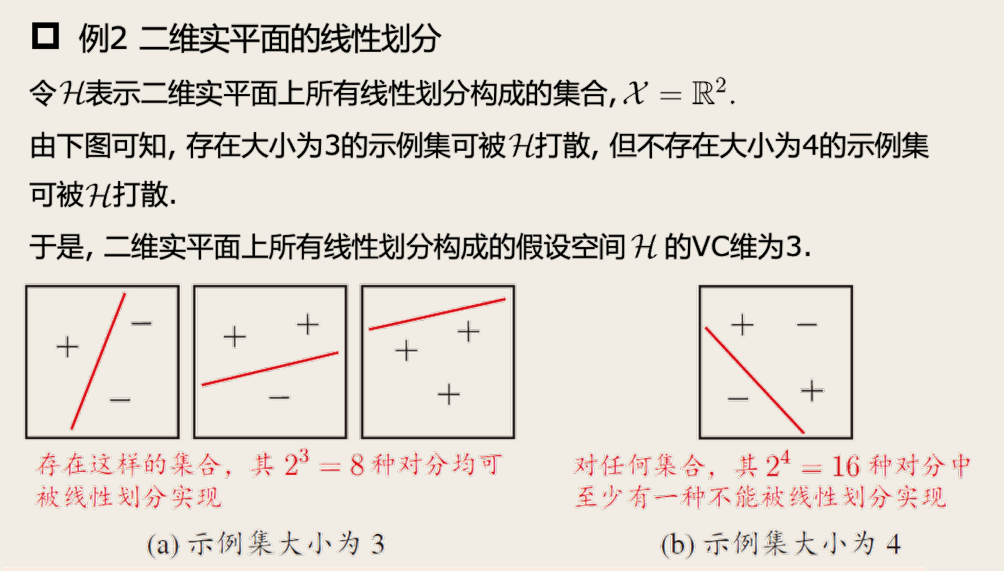

下面是另一个例子,二维实平面的线性划分。

对于 VC 维与增长函数之间的定量关系,有

Sauer 引理

若 H \mathcal{H} H d d d m ∈ N m \in \N m ∈ N

π H ( m ) ⩽ ∑ i = 0 d ( m i ) \pi_{\mathcal{H}}(m) \le \sum_{i=0}^d \binom{m}{i}

π H ( m ) ⩽ i = 0 ∑ d ( i m )

由此可计算出增长函数的上界,有引理

对任意整数 m ⩾ d m \ge d m ⩾ d

Π H ( m ) ⩽ ( e m d ) d \Pi_{\mathcal{H}}(m) \le \left( \dfrac{\e m}{d} \right)^d

Π H ( m ) ⩽ ( d e m ) d

基于 VC 维的泛化误差界:

若假设空间 H \mathcal{H} H d d d m > d , 0 < δ < 1 m > d, 0 < \delta < 1 m > d , 0 < δ < 1 h ∈ H h \in \mathcal{H} h ∈ H

P ( ∣ E ( h ) − E ^ ( h ) ∣ ⩽ 8 d ln ( 2 e m / d ) + 8 ln ( 4 / δ ) m ) ⩾ 1 − δ P\left( |E(h) - \hat{E}(h)| \le \sqrt{\dfrac{8d \ln(2 \e m / d) + 8 \ln (4 / \delta)}{m}} \right) \ge 1 - \delta

P ( ∣ E ( h ) − E ^ ( h ) ∣ ⩽ m 8 d ln ( 2 e m / d ) + 8 ln ( 4/ δ ) ) ⩾ 1 − δ

上式的泛化误差界仅与样例数目 m m m D \mathcal{D} D D D D O ( 1 m ) O\left( \dfrac{1}{\sqrt{m}} \right) O ( m 1 )

因此基于 VC 维的泛化误差界有分布无关 (distribution-free)性与数据独立 (data-independent)性。

类似地,上面的定理能看出,当假设空间的 VC 维有限且样本大小 m m m h h h

因此对于满足经验风险最小化原则的学习算法 L \mathfrak{L} L

任何 VC 维有限的假设空间 H \mathcal{H} H

Rademacher 复杂度

由于基于 VC 维的泛化误差界是分布无关与数据独立的,因此基于 VC 维的可学习性分析结果具有一定的普适性,但同时因为没有考虑数据自身,因此得到的泛化误差界比较松。

Rademacher 复杂度是另一种刻画假设空间复杂的的途径,它在一定程度上考虑了数据分布。

给定数据集 D = { ( x i , y i ) } i = 1 m D = \left\lbrace (\bm{x}_i, y_i) \right\rbrace_{i=1}^m D = { ( x i , y i ) } i = 1 m h h h

E ^ ( h ) = 1 m ∑ i = 1 m I ( h ( x i ) ≠ y i ) = 1 m ∑ i = 1 m 1 − y i h ( x i ) 2 = 1 2 − 1 2 m ∑ i = 1 m y i h ( x i ) \begin{aligned}

\hat{E}(h) &= \dfrac{1}{m} \sum_{i=1}^m \mathbb{I}(h(\bm{x}_i) \ne y_i) \\

&= \dfrac{1}{m} \sum_{i=1}^{m} \dfrac{1 - y_i h(\bm{x}_i)}{2}\\

&= \dfrac{1}{2} - \dfrac{1}{2m} \sum_{i=1}^m y_i h(\bm{x}_i)

\end{aligned}

E ^ ( h ) = m 1 i = 1 ∑ m I ( h ( x i ) = y i ) = m 1 i = 1 ∑ m 2 1 − y i h ( x i ) = 2 1 − 2 m 1 i = 1 ∑ m y i h ( x i )

其中 1 m ∑ i = 1 m y i h ( x i ) \displaystyle \dfrac{1}{m}\sum_{i=1}^{m}y_ih(\bm{x}_i) m 1 i = 1 ∑ m y i h ( x i ) h ( x i ) h(\bm{x}_i) h ( x i ) y i y_i y i

若对任意 i ∈ { 1 , 2 , … , m } i \in \left\lbrace 1, 2, \dots, m \right\rbrace i ∈ { 1 , 2 , … , m } h ( x i ) = y i h(\bm{x}_i) = y_i h ( x i ) = y i 1 m ∑ i = 1 m y i h ( x i ) \dfrac{1}{m} \displaystyle \sum_{i=1}^{m}y_i h(\bm{x}_i) m 1 i = 1 ∑ m y i h ( x i ) 1 1 1

arg max h ∈ H 1 m ∑ i = 1 m y i h ( x i ) \argmax_{h \in \mathcal{H}} \dfrac{1}{m} \sum_{i=1}^m y_i h(\bm{x}_i)

h ∈ H arg max m 1 i = 1 ∑ m y i h ( x i )

若假设标签 y i y_i y i x i \bm{x}_i x i H \mathcal{H} H

sup h ∈ H 1 m ∑ i = 1 m σ i h ( x i ) \sup_{h \in \mathcal{H}} \dfrac{1}{m} \sum_{i=1}^m \sigma_i h(\bm{x}_i)

h ∈ H sup m 1 i = 1 ∑ m σ i h ( x i )

其中 σ i \sigma_i σ i 0.5 0.5 0.5 1 1 1 0.5 0.5 0.5 − 1 -1 − 1

考虑 H \mathcal{H} H

E σ [ sup h ∈ H 1 m ∑ i = 1 m σ i h ( x i ) ] \mathbb{E}_{\bm{\sigma}} \left[ \sup_{h \in \mathcal{H}} \dfrac{1}{m} \sum_{i=1}^m \sigma_i h(\bm{x}_i) \right]

E σ [ h ∈ H sup m 1 i = 1 ∑ m σ i h ( x i ) ]

其中 σ = { σ i } i = 1 m \bm{\sigma} = \left\lbrace \sigma_i \right\rbrace_{i=1}^m σ = { σ i } i = 1 m

这个式子的取值范围为 [ 0 , 1 ] [0, 1] [ 0 , 1 ] H \mathcal{H} H

当 ∣ H ∣ = 1 |\mathcal{H}| = 1 ∣ H ∣ = 1 H \mathcal{H} H 0 0 0

当 ∣ H ∣ = 2 m |\mathcal{H}| = 2^m ∣ H ∣ = 2 m H \mathcal{H} H D D D σ \bm{\sigma} σ h ( x i ) = σ i h(\bm{x}_i) = \sigma_i h ( x i ) = σ i 1 1 1

Rademacher 复杂度定义为

Rademacher 复杂度(Rademacher complexity)

函数空间 F \mathcal{F} F Z Z Z

R ^ Z ( F ) = E σ [ sup f ∈ F 1 m ∑ i = 1 m σ i f ( x i ) ] \hat{R}_{Z}(\mathcal{F}) = \mathbb{E}_{\bm{\sigma}} \left[ \sup_{f \in \mathcal{F}} \dfrac{1}{m} \sum_{i=1}^m \sigma_i f(\bm{x}_i) \right]

R ^ Z ( F ) = E σ [ f ∈ F sup m 1 i = 1 ∑ m σ i f ( x i ) ]

其中 F : Z → R \mathcal{F}\colon \mathcal{Z} \to\R F : Z → R Z = { z i } i = 1 m Z = \left\lbrace z_i \right\rbrace_{i=1}^m Z = { z i } i = 1 m z i ∈ Z z_i \in \mathcal{Z} z i ∈ Z

函数空间 F \mathcal{F} F Z Z Z D \mathcal{D} D

R m ( F ) = E Z ⊆ Z : ∣ Z ∣ = m [ R ^ Z ( F ) ] R_m(\mathcal{F}) = \mathbb{E}_{Z \subseteq \mathcal{Z}\colon |Z| = m} \left[ \hat{R}_{Z}(\mathcal{F}) \right]

R m ( F ) = E Z ⊆ Z : ∣ Z ∣ = m [ R ^ Z ( F ) ]

经验 Rademacher 复杂度衡量了函数空间 F \mathcal{F} F Z Z Z R ^ Z ( F ) \hat{R}_{Z}(\mathcal{F}) R ^ Z ( F ) F \mathcal{F} F Z Z Z F \mathcal{F} F

基于 Rademacher 复杂度可得关于函数空间 F \mathcal{F} F

对实值函数空间 F : Z → [ 0 , 1 ] \mathcal{F}\colon \mathcal{Z} \to[0, 1] F : Z → [ 0 , 1 ] D \mathcal{D} D Z \mathcal{Z} Z Z = { z 1 , z 2 , … , z m } Z = \left\lbrace z_1, z_2, \dots, z_m \right\rbrace Z = { z 1 , z 2 , … , z m } z i ∈ Z , 0 < δ < 1 z_i \in \mathcal{Z}, 0 < \delta < 1 z i ∈ Z , 0 < δ < 1 f ∈ F f \in \mathcal{F} f ∈ F 1 − δ 1 - \delta 1 − δ

E [ f ( z ) ] ⩽ 1 m ∑ i = 1 m f ( z i ) + 2 R m ( F ) + ln ( 1 / δ ) 2 m E [ f ( z ) ] ⩽ 1 m ∑ i = 1 m f ( z i ) + 2 R ^ Z ( F ) + 3 ln ( 2 / δ ) 2 m \begin{aligned}

\mathbb{E}[f(z)] &\le \dfrac{1}{m} \sum_{i=1}^{m}f(z_i) + 2R_m(\mathcal{F}) + \sqrt{\dfrac{\ln(1 / \delta)}{2 m}}\\

\mathbb{E}[f(z)] &\le \dfrac{1}{m} \sum_{i=1}^{m}f(z_i) + 2\hat{R}_{Z}(\mathcal{F}) + 3\sqrt{\dfrac{\ln(2 / \delta)}{2 m}}

\end{aligned}

E [ f ( z )] E [ f ( z )] ⩽ m 1 i = 1 ∑ m f ( z i ) + 2 R m ( F ) + 2 m ln ( 1/ δ ) ⩽ m 1 i = 1 ∑ m f ( z i ) + 2 R ^ Z ( F ) + 3 2 m ln ( 2/ δ )

上面的函数空间 F \mathcal{F} F [ 0 , 1 ] [0, 1] [ 0 , 1 ]

对假设空间 H : X → { − 1 , 1 } \mathcal{H}\colon \mathcal{X} \to \left\lbrace -1, 1 \right\rbrace H : X → { − 1 , 1 } D \mathcal{D} D X \mathcal{X} X D = { x i } i = 1 m D = \left\lbrace \bm{x}_i \right\rbrace_{i=1}^m D = { x i } i = 1 m x i ∈ X , 0 < δ < 1 \bm{x}_i \in \mathcal{X}, 0 < \delta < 1 x i ∈ X , 0 < δ < 1 h ∈ H h \in \mathcal{H} h ∈ H 1 − δ 1 - \delta 1 − δ

E ( h ) ⩽ E ^ ( h ) + R m ( H ) + ln ( 1 / δ ) 2 m E ( h ) ⩽ E ^ ( h ) + R ^ D ( H ) + 3 ln ( 2 / δ ) 2 m \begin{aligned}

E(h) &\le \hat{E}(h) + R_m(\mathcal{H}) + \sqrt{\dfrac{\ln(1 / \delta)}{2 m}}\\

E(h) &\le \hat{E}(h) + \hat{R}_{D}(\mathcal{H}) + 3\sqrt{\dfrac{\ln(2 / \delta)}{2 m}}

\end{aligned}

E ( h ) E ( h ) ⩽ E ^ ( h ) + R m ( H ) + 2 m ln ( 1/ δ ) ⩽ E ^ ( h ) + R ^ D ( H ) + 3 2 m ln ( 2/ δ )

上面的定理就适合二分类问题。

Rademacher 复杂度与增长函数之间的关系有

假设空间 H \mathcal{H} H R m ( H ) R_m(\mathcal{H}) R m ( H ) Π H ( m ) \Pi_{\mathcal{H}}(m) Π H ( m )

R m ( H ) ⩽ 2 ln Π H ( m ) m R_m(\mathcal{H}) \le \sqrt{\dfrac{2 \ln\Pi_{\mathcal{H}}(m)}{m}}

R m ( H ) ⩽ m 2 ln Π H ( m )

综合可得

E ( h ) ⩽ E ^ ( h ) + 2 d ln ( e m / d ) m + ln ( 1 / δ ) 2 m E(h) \le \hat{E}(h) + \sqrt{\dfrac{2d \ln(\e m / d)}{m}} + \sqrt{\dfrac{\ln(1 / \delta)}{2m}}

E ( h ) ⩽ E ^ ( h ) + m 2 d ln ( e m / d ) + 2 m ln ( 1/ δ )

稳定性

基于 VC 维和 Rademacher 复杂度分析泛化性能,得到的结果均与具体的学习算法无关,可使得人们脱离具体的学习算法考虑学习问题本身的性质。

为了获得与算法有关的分析结果,可以考察算法在输入(训练集)发生变化时,输出是否发生较大的变化,即「稳定性」。

给定 D = { z i = ( x i , y i ) } i = 1 m D = \left\lbrace \bm{z}_i = (\bm{x}_i, y_i) \right\rbrace_{i=1}^m D = { z i = ( x i , y i ) } i = 1 m x i ∈ X \bm{x}_i \in \mathcal{X} x i ∈ X D \mathcal{D} D y i ∈ Y = { − 1 , 1 } y_i \in \mathcal{Y} = \left\lbrace -1, 1 \right\rbrace y i ∈ Y = { − 1 , 1 }

对假设空间 H : X → { − 1 , 1 } \mathcal{H}\colon \mathcal{X} \to \left\lbrace -1, 1 \right\rbrace H : X → { − 1 , 1 } L \mathfrak{L} L L D ∈ H \mathfrak{L}_D \in \mathcal{H} L D ∈ H D D D H \mathcal{H} H

D ∖ i D^{\setminus i} D ∖ i D D D i i i { z 1 , … , z i − 1 , z i + 1 , … , z m } \left\lbrace \bm{z}_1, \dots, \bm{z}_{i-1}, \bm{z}_{i+1}, \dots, \bm{z}_m \right\rbrace { z 1 , … , z i − 1 , z i + 1 , … , z m } D i D^i D i D D D i i i { z 1 , … , z i − 1 , z ′ , z i + 1 , … , z m } \left\lbrace \bm{z}_1, \dots, \bm{z}_{i-1}, \bm{z}', \bm{z}_{i+1}, \dots, \bm{z}_m \right\rbrace { z 1 , … , z i − 1 , z ′ , z i + 1 , … , z m } z ′ = ( x ′ , y ′ ) \bm{z}' = (\bm{x}', y') z ′ = ( x ′ , y ′ ) x i ′ \bm{x}_i' x i ′ D \mathcal{D} D D D D

损失函数 ℓ ( L D ( x ) , y ) : Y × Y → R + \ell(\mathfrak{L}_D(\bm{x}), y)\colon \mathcal{Y} \times \mathcal{Y} \to \R^{+} ℓ ( L D ( x ) , y ) : Y × Y → R + L D \mathfrak{L}_D L D L D ( x ) \mathfrak{L}_D(\bm{x}) L D ( x ) y y y ℓ ( L D , z ) \ell(\mathfrak{L}_D, \bm{z}) ℓ ( L D , z )

泛化损失:ℓ ( L , D ) = E x ∈ X , z = ( x , y ) [ ℓ ( L D , z ) ] \ell(\mathfrak{L}, D) = \mathbb{E}_{\bm{x} \in \mathcal{X}, \bm{z} = (\bm{x}, y)}\left[ \ell(\mathfrak{L}_D, \bm{z}) \right] ℓ ( L , D ) = E x ∈ X , z = ( x , y ) [ ℓ ( L D , z ) ]

经验损失:ℓ ^ ( L D , D ) = 1 m ∑ i = 1 m ℓ ( L D , z i ) \hat{\ell}(\mathfrak{L}_D, D) = \dfrac{1}{m} \sum_{i=1}^m \ell(\mathfrak{L}_D, \bm{z}_i) ℓ ^ ( L D , D ) = m 1 ∑ i = 1 m ℓ ( L D , z i )

留一(leave-one-out)损失:ℓ loo ( L D , D ) = 1 m ∑ i = 1 m ℓ ( L D ∖ i , z i ) \ell_{\text{loo}}(\mathfrak{L}_D, D) = \dfrac{1}{m} \sum_{i=1}^m \ell(\mathfrak{L}_{D^{\setminus i}}, \bm{z}_i) ℓ loo ( L D , D ) = m 1 ∑ i = 1 m ℓ ( L D ∖ i , z i )

算法的均匀稳定性(uniform stability)

对任何 x ∈ X , z = ( x , y ) \bm{x} \in \mathcal{X}, \bm{z} = (\bm{x}, y) x ∈ X , z = ( x , y ) L \mathfrak{L} L

∣ ℓ ( L D , z ) − ℓ ( L D ∖ i , z ) ∣ ⩽ β \left\lvert \ell(\mathfrak{L}_D, \bm{z}) - \ell(\mathfrak{L}_{D^{\setminus i}}, \bm{z}) \right\rvert \le \beta

∣ ℓ ( L D , z ) − ℓ ( L D ∖ i , z ) ∣ ⩽ β

则称 L \mathfrak{L} L ℓ \ell ℓ β \beta β

若算法 L \mathfrak{L} L ℓ \ell ℓ β \beta β

∣ ℓ ( L D , z ) − ℓ ( L D i , z ) ∣ ⩽ ∣ ℓ ( L D , z ) − ℓ ( L D ∖ i , z ) ∣ + ∣ ℓ ( L D ∖ i , z ) − ℓ ( L D i , z ) ∣ ⩽ 2 β \begin{aligned}

\left\lvert \ell(\mathfrak{L}_D, \bm{z}) - \ell(\mathfrak{L}_{D^{i}}, \bm{z}) \right\rvert &\le \left\lvert \ell(\mathfrak{L}_D, \bm{z}) - \ell(\mathfrak{L}_{D^{\setminus i}}, \bm{z}) \right\rvert + \left\lvert \ell(\mathfrak{L}_{D^{\setminus i}}, \bm{z}) - \ell(\mathfrak{L}_{D^{i}}, \bm{z}) \right\rvert \\

&\le 2 \beta

\end{aligned}

∣ ℓ ( L D , z ) − ℓ ( L D i , z ) ∣ ⩽ ∣ ℓ ( L D , z ) − ℓ ( L D ∖ i , z ) ∣ + ∣ ℓ ( L D ∖ i , z ) − ℓ ( L D i , z ) ∣ ⩽ 2 β

也即,移除示例的稳定性包含替换示例的稳定性。

若损失函数 ℓ \ell ℓ D D D z = ( x , y ) \bm{z} = (\bm{x}, y) z = ( x , y ) 0 ⩽ ℓ ( L D , z ) ⩽ M 0 \le \ell(\mathfrak{L}_D, \bm{z}) \le M 0 ⩽ ℓ ( L D , z ) ⩽ M

给定从分布 D \mathcal{D} D m m m D D D L \mathfrak{L} L ℓ \ell ℓ β \beta β ℓ \ell ℓ M M M 0 < δ < 1 0 < \delta < 1 0 < δ < 1 m ⩾ 1 m \ge 1 m ⩾ 1 1 − δ 1 - \delta 1 − δ

ℓ ( L , D ) ⩽ ℓ ^ ( L , D ) + 2 β + ( 4 m β + M ) ln ( 1 / δ ) 2 m ℓ ( L , D ) ⩽ ℓ loo ( L , D ) + β + ( 4 m β + M ) ln ( 1 / δ ) 2 m \begin{aligned}

\ell(\mathfrak{L}, \mathcal{D}) &\le \hat{\ell}(\mathfrak{L}, D) + 2\beta + (4 m \beta + M) \sqrt{\dfrac{\ln(1 / \delta)}{2m}}\\

\ell(\mathfrak{L}, \mathcal{D}) &\le \ell_{\text{loo}}(\mathfrak{L}, D) + \beta + (4 m \beta + M) \sqrt{\dfrac{\ln(1 / \delta)}{2m}}

\end{aligned}

ℓ ( L , D ) ℓ ( L , D ) ⩽ ℓ ^ ( L , D ) + 2 β + ( 4 m β + M ) 2 m ln ( 1/ δ ) ⩽ ℓ loo ( L , D ) + β + ( 4 m β + M ) 2 m ln ( 1/ δ )

上面的定理给出了基于稳定性分析推导出的学习算法 L \mathfrak{L} L

经验误差与泛化损失之间差别的收敛率为 β m \beta \sqrt{m} β m β = O ( 1 m ) \beta = O\left(\dfrac{1}{m}\right) β = O ( m 1 ) O ( 1 m ) O\left(\dfrac{1}{\sqrt{m}}\right) O ( m 1 )

学习算法的稳定性分析关注的是 ∣ ℓ ^ ( L , D ) − ℓ ( L , D ) ∣ |\hat{\ell}(\mathfrak{L}, D) - \ell(\mathfrak{L}, \mathcal{D})| ∣ ℓ ^ ( L , D ) − ℓ ( L , D ) ∣ sup h ∈ H ∣ E ( h ) − E ^ ( h ) ∣ \sup\limits_{h \in \mathcal{H}} |E(h) - \hat{E}(h)| h ∈ H sup ∣ E ( h ) − E ^ ( h ) ∣

因此稳定性分析不必考虑假设空间中所有可能的假设,只需根据分析算法自身的特性(稳定性)来讨论输出假设 L D \mathfrak{L}_D L D

必须假设 β m → 0 \beta \sqrt{m} \to 0 β m → 0

对于满足 ERM(即经验风险最小化)原则的学习算法,有

若学习算法是 ERM 且稳定的,则假设空间 H \mathcal{H} H

学习算法的稳定性能导出假设空间的可学习性。稳定性和假设空间可通过损失函数 ℓ \ell ℓ